Viele Webdeveloper kennen das Problem sicherlich: Man sitzt zu Hause vor der dicken Leitung mit 25, 50 oder gar 100 MBit und baut z.B. eine mobile Version einer Website. Schwer vorstellbar, wie da die Ladezeiten im wirklichen Leben auf mobilen Endgeräten aussehen. Und das komplette Kontingent seiner Daten’flatrate’ will man ja auch nicht mit Tests aufbrauchen.

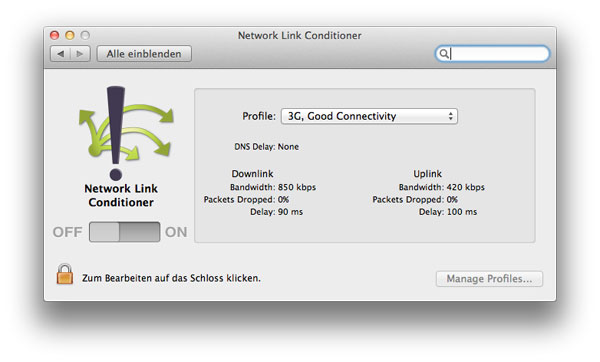

Abhilfe kommt von Apple. Im neuen XCode 4.1 (kostenlos) für Max OS X Lion (10.7) findet sich, versteckt unter /Programme/Dienstprogramme (bei manchen auch unter /Developer/Applications/Utilities) ein Ordner Namens Network Link Conditioner.

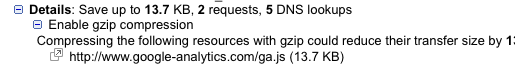

Klickt man die Prefpane-Datei doppelt, die sich darin befindet, installiert sich ein neuer Eintrag in den Systemeinstellungen, über den man verschiedenste Zugänge und Leitungsqualitäten simulieren kann. Apple hat bereits diverse Profile angelegt, eigene Konfigurationen kann man problemlos hinzufügen. Und dann kann man feststellen, dass beispielsweise diese Seite über VDSL50 in knapp zwei Sekunden lädt, während sie über gutes 3G-Netz ca. 10 mal so lange braucht.

Es wäre schön, wenn Apple dieses Utility einzeln zum Download anbieten oder direkt mit Lion ausliefern würde, derzeit bleibt einem nur der 3GB große XCode-Download. Nur dafür lohnt sich das sicherlich nicht, alle, die XCode sowieso installiert haben, bekommen aber ein nützliches kleines Helferlein für die tägliche Arbeit an die Hand.