Wenn man am Vortag die Ehre hatte, den Chauffeur zu spielen, ist es relativ einfach, am nächsten Tag fit und ausgeschlafen auf der Matte zu stehen. OK, Pingdom hat mich gegen zwei mal geweckt, aber sonst war die Nacht ruhig, bis im Hotel die große Unruhe ausbrach, was aufgrund der Hellhörigkeit des Hauses auch an mir nicht spurlos vorbeiging. Ich will aber nicht schon wieder nörgeln, man sagt mir eh nach, ich wäre viel zu negativ.

Erste Session des Tages: Thomas Zeithaml zu interner Verlinkung. Ein abendfüllendes Thema. Locker-knackig in 50 Minuten untergebracht. Und was ich allein in dieser kurzen Zeit an Problemen und Problemchen ausgemacht habe – da kommt Arbeit auf mich zu.

Bei Sasa Ebach ging es im Anschluß darum, ein fiktivies Projekt mit 1 Milliarde Euro (das ist so eine Zahl mit neun Nullen hintendran) in einem stark umkämpften Bereich, im konkreten Fall Auto, nach oben zu bringen. Ebach ging es dabei primär um den Linkaufbau und um die Mittel und Wege, Links organisch zu bekommen. Nichts, was ich machen möchte, aber auch nichts, was augenscheinlich unmöglich ist. Selbst in hart umkämpften Umfeldern nicht.

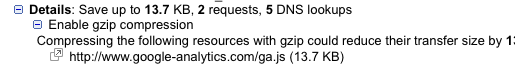

Nach der Mittagspause war ich dann im proppenvollen Raum bei SEO technisch mit Markus Orlinski. Der Vortrag ist mittlerweile online. Im Großen und Ganzen war es ein Rundumschlag über die ganzen Themen, denen man unter technischen Gesichtspunkten Aufmerksamkeit schenken muss: Crawlability, Performance, Internationalisierung. Markus schien mir etwas aufgeregt, ansonsten habe ich aus dem Vortrag viel hilfreiches mitgenommen – vor allem im Hinblick auf internationale Projekte. Wenn’s auch jetzt nicht unbedingt japanische sind.

Ein anderer Marcus war dahingegen cool wie immer. Marcus Tandler, besser bekannt als Mediadonis, zog mal wieder eine perfekte Show ab. Ich schau ihm wirklich gerne zu. Er ist ein großartiger Entertainer. Und er hat ein Branding für seine Person, da könnte sich manche Firma eine dicke Scheibe abschneiden. Genug geschleimt. Ist ehrlich gemeint. Und außerdem war Blog-/Twitter-/Fotografierverbot.

Das letzte Panel haben wir sausen lassen. Eine gute Entscheidung. Denn schon als wir losgefahren sind ist in Berlin noch einmal der Winter ausgebrochen. Und das muss ziemlich heftig gewesen sein:

Chaos am Flughafen Tegel – zwar mittlerweile im Flieger, aber laut Pilot geht’s erst in 2 Stunden los… Das is ma doof.. #DoofesSchneechaos

Marcus Tandler um 18:37

Ja, ich hoff jetzt auch mal auf bessere Verhältnisse, wage mich jetzt mal aus dem Autbahn-Restaurant wieder auf die A10 #campixx #Seocampixx

SeoSocke um 19:35

Ich hoffe ihr seit mittlerweile alle gut zu Hause angekommen.

Pro’s und Con’s

T-Shirts

Super Idee. Man muss nicht zwanghaft versuchen, einen Blick auf den Teilnehmerausweis zu erhaschen, um zu wissen, wer der (respektive die, Frauenquote war relativ hoch) andere ist. Den Namen auf der Brust vorne nochmal zu wiederholen wäre dabei aber auch hilfreich. Bei der Anmeldung hätte aber klar sein sollen, was da als ‘Name’ aufgedruckt wird. Dann hätte ich nämlich sicher nicht ‘matt’ angegeben, sondern msslovi0. Und es sollten wirklich alle das T-Shirt anziehen. Sonst bringt das irgendwie nichts.

Essen

Schnell auf Kritik reagiert, Hut ab. Und das, obwohl ich sie in meiner bekannt überheblichen Art und Weise geäußert habe. Vielleicht war ich aber auch gar nicht der Auslöser. Es würde mir aber auch nichts ausmachen, wenn man mich weiterhin in dem Glauben lässt, es gewesen zu sein. Das Abendessen am Grillhähnchenstand war super. Genau das richtige. Schnell was auf die Hand, schnell satt. Zum Mittagessen eher ausgefallenere Sachen der griechischen und italienischen Küche zu kredenzen fand ich dann doch etwas übertrieben. Da hätten es ein paar Schnitzel oder Steaks auch getan.

Socialising

Wenn du keinen kennst, dann kennst du nach der Veranstaltung nur wenige mehr. Der Netzwerkgedanke kommt meiner Meinung nach zu kurz. Wer sich eh kennt steht in Grüppchen zusammen und es ist schwer für den Außenstehenden, da ‘einzudringen’. Man will ja auch nicht den Elefanten im Porzellanladen spielen. Vielleicht sollte ich mit dem Rauchen anfangen. Für die scheint das leichter zu sein. Aber es ist nicht so, dass wir gar keine neuen Kontakte geknüpft hätten.

Technik

Das muss ich noch grad mal loswerden: Die (gefühlte) iPhone-Quote lag bei 90%. Ich bin mir noch nicht sicher, ob ich das toll finde oder ob es mir Angst macht. Da so ein Tag ziemlich akkumordend ist, wäre es gut, wenn man in den einzelnen Räumen leicht zugängliche Steckdosen hätte, quasi Ladestationen. Vielleicht könnte man sogar einen Hersteller wie Powermat dazu bringen, die Veranstaltung entsprechend auszurüsten.

Sessionbenennung

Wenn ich gewusst hätte, dass es bei „Pimp my Feed” um Google Base Tuning geht, dann wäre ich da wohl auch hin, anstatt mich in der xt:Commerce-Session zu langweilen. Das soll nämlich sehr interessant gewesen sein. Leider war da Blogverbot, somit ist auch im Nachhinein nichts darüber zu erfahren. Schade.

Veranstaltung allgemein

Insgesamt super. Also rundum. Perfekte Organisation von Marco Janck und seinem Team.

Ein Hotel im letzten Zipfel von Berlin, damit da auch keiner wegrennt. Macht halt auch das hinrennen etwas schwierig, aber man kann nicht alles haben.

Problematischer finde ich, dass die ganzen SEO-Veranstaltungen sehr auf Norddeutschland konzentriert scheinen, sei es die SEMSEO in Hannover oder die SEO CAMPIXX in Berlin. Irgendwer sollte mal im Rhein-Main-Gebiet die Initiative ergreifen.

Trotz oder gerade wegen aller Kleinigkeiten, und mehr ist das, was ich da oben zu kritisieren habe, nicht:

Schlussfazit

Rundum zufrieden.